人事の可能性を無限にするAIで組織と人を幸せにする(前編):リスクを知る

こんにちはFunleashの志水です。毎日猛暑が続き、なかなか勉強に身が入らない日々・・と思っていたら、東京大学未来ビジョン研究センターが主催する「AIサービスに対するリスクベースアプローチ:リスクチェーンモデルと採用AI」というちょっと難しそうなセミナーへの登壇の機会をいただきました。

東京大学未来ビジョンセンターでは、人工知能(以下AI)サービスの進展に伴って今後引き起こされるリスクシナリオをあらかじめ想定し、幅広い観点からリスク要因をコントロールする研究を行っています。(当日のセミナーについては後日動画が配信される予定です。もし興味のある方はこちらもぜひご覧ください)

このNoteはつまらなそうだから読むのやめよう。そう言わずに最後までお付き合いください笑

AIを仕事で使っているか否かに関わらず、今の時代テクロノジーの影響を受けていない人は誰一人いません。

ネットで買い物をしているときに「あれ?なぜこの商品が推薦されるのだろう?」と思うことはありませんか?

AIを使うのは企業側かもしれませんが、データを使われる側としてどのようなデータが取得され、どんな目的で使われているのかを理解しておくことは重要だと思います。知らないうちに個人データをもとに私たちの行動や嗜好が分析され、見えないところで誰かから「選別」されているかもしれない。そんな社会で私たちは生活しているのです。

最初に依頼がきた時は自分の専門外なのでお断りしようかなとも思いました。けれども、グローバル及び日本企業の人材マネジメントに精通していて、AIサービスのリスクについてざっくばらんに話せれば良いということだったので引き受けました。

セミナーの論点を整理して発信すれば自身の(もしかしたら皆さんの)理解が深まるきっかけになるかもしれないと思ったのです。

よほどのマニアじゃない限り、このテーマを見てわざわざHPにアクセスしてAI ガイドラインや政策提言を読むなんてことはしないですからね(少なくとも私は)

ドキドキしながら参加したところ、かなり刺激的で、かつ非常に意義のある研究、実務に役立つと感じたのでNoteに書こうと思いました。

さて前置きが長くなりましたが・・

皆さんはAIと人事という言葉を聞いたら何を思い浮かべますか?

少し前の記事ですが、就職情報サイト「リクナビ」が内定辞退率を学生本人に無断で顧客に販売したというリクナビ問題を覚えていらっしゃいますか?これは企業における個人データの使用に関する警鐘でしたね。

この問題をきっかけに、個人情報保護の観点から法整備やガイドライン策定の必要性に関する議論が活発になったことは記憶に新しいところです。

もう一つの例です。採用AIツールの開発に取り組んでいたアマゾン社は以下の理由でAIの開発・使用を中止しました。

・AIが女性に対して好意的ではない評価を行った

・採用すべき人材の学習に使用した履歴書の大半が男性の履歴書だったことが主な原因だった

自社でAIを開発・研究・利用している最先端のグローバル企業においてこんな問題が起こればAIの活用に躊躇する企業がでてきても不思議ではないですよね。

ご承知の通り、AIというのは単体のシステムではなくその技術は200以上にも及びます。

その中でも人事領域で一番活用されているのが「ディープラーニング」、つまり機械学習の一種です。

AIに大量のデータを与えてラベリング(データサンプルを検出しタグ付けするプロセス)し、そこからパターンを抽出する。これを繰り返すことで自ら学習する能力が高まり、精度の高い分析や予測を行うことが可能になる。その結果を採用や配置などに活用する。

こんなに便利な道具ならば人事の現場で爆発的に使われているのかなと思いきや、現場の方々に聞くとAIのメリットよりもリスクに関する不安を口にする人が目立ちました。「以前は使っていたけどリスクが高いのでやめてしまった」このような声さえ聞こえてきました。

AIに関するさまざまな調査を調べて見ると、「かなり期待する」「ビジネスに革命を起こす」というポジティブな声も多い中、一方で「人の能力を超えてしまうかも」「人間の仕事を奪ってしまうかも」「結果の説明ができない」など不安の声が多いこともわかりました。

AIのメリットを提唱する研究者と一般人の間にかなり分断があるかもしれない。

ユーザーの不安や不信はどこからきているのだろう?

実際にAIサービスを使っている人たちはリスクをどうコントロールしているのだろう? 次々と疑問がわいてきます。

そうだ、こんなときは専門家から助言をもらおう!

「実務専門家」とは、ある領域において教育や訓練を受けたり、専門組織から資格の認定を受けている人たち。かつ実務において豊富な経験があるプロだと私は定義しています。

昨今はネットに氾濫する記事などをさっと読み、表面的なことを少しかじっただけで、あたかも知識人のように発言する(特に人事領域で)生かじりインフルエンサーの増加、それを盲目的に信じるフォロアーを見て危険だと個人的には思っています。

AIサービスの仕組みは理解していても実務については門外漢なので、登壇するからにはきちんと事前準備をして臨みたい。そう思って本や事例、論文などを読んでまずは基本的なことをおさらいしました。

次に自分のネットワークの中から知識・経験が豊富な実務専門家にインタビューをお願いして助言をいただきました。(インタビュー内容は結構な分量なので重要なポイントだけに絞ります)

「AIって聞くとまずは発生するリスクを想定して不安に思う人がいる人が多いようです。実際にどのようなリスクが想定されると思いますか?」

この問いに対して一番多かった回答から選んだリスクのトップ3は以下の通り。(後述しますが想定されるリスクは多岐におよびます)

①データのバイアス:AIが学習したデータが偏っていたり、断片的だったりした場合に、偏ったデータがそのまま使われる。また、データ個別では問題ないが、データの組み合わせによって類推されることで公平性や客観性を欠く判断を下してしまう。

②アウトプットのブラックボックス化:大量データからパターンをあてはめて結論を導き出す際に、結論に至った過程や根拠をディープラーニングは示せない。仮に示せたとしてもアルゴリズムが複雑・専門的すぎて一般の人には理解できない。

③データの保護およびセキュリティの維持:データへの不正アクセスによる攻撃やシステム障害、災害などで失われるリスク。また人に関わるセンシティブなデータの漏洩や誰に開示するかなどデータの安全性に関する点。

なるほどその通りですね。

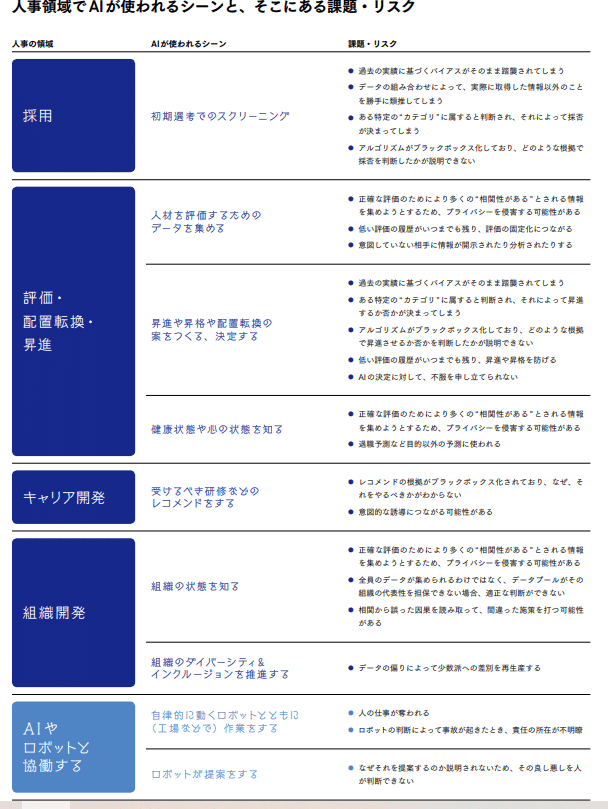

人事領域において使われるシーンと想定されるリスクがわかりやすくまとまっている図もあわせて引用します。(少々見づらいので出所の資料をご確認ください。出所:Works 156 「人事のAI原則」の19頁)

上記で実務専門家が指摘した③つのリスクは、すべて下記の図に網羅されています。ざっと見るだけでもAI活用において多くの課題とリスクが散見されます。

これらのリスクが人々の不安や不信をかきたてていることは明らかです。

さらに、AIの信頼性をめぐる原則やガイドラインについては国際機関、各国の政府、研究機関や大学など多くの機関からすでに発行されているようです。

日本でも総務省情報政策研究所からAI利活用ガイドラインが公開されているそうです。【参考】政策提言「AIサービスのリスク低減を検討するリスクチェーンモデルの提案」

どれどれ・・私も早速アクセスしてみました。

わーなんじゃこりゃ!

確かに調べてみると有識者や研究者によって発行されているAIガイドラインや倫理指針には、一般的な論点や注意点が網羅されています。けれども膨大で広範囲に渡る資料はなかなか頭に入ってきません。

AIの信頼性に関わるリスクは複数の要因が絡み合っていてます。そのリスクの要因は学習済みAIモデルなのか、学習データそのものなのか、サービス提供者なのか、利用者なのか、利用環境なのか・・

それぞれのリスクが複雑に絡みあっているために、リスクを検討するにあたってどこにフォーカスすればよいのか、実はわかりづらいのです。

と、ここで冒頭のセミナーに話を戻します。

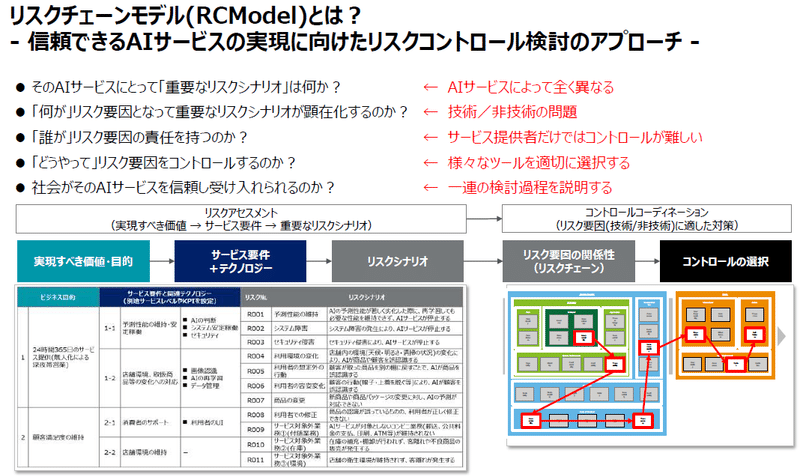

先日私が登壇したイベントでは、東大の研究グループが開発した「リスクチェーンモデル」(後ほど詳述します)を活用しながら、採用AIを事例として取り上げました。

AIサービスや製品に関して

・重要なリスクは何なのか

・誰がそのリスクに責任を持つのか

・どのようにしてリスク対策(ツールの選択等)を検討するのか。

当日は、このようなさまざまな論点を整理しつつ、「ガイドラインや原則」を実際の業務に落して議論を進めたのとてもわかりやすかったのです。

では「リスクチェーンモデル」とは一体どんなものでしょうか?人事はもちろん、組織と個人にとってメリットがあるのでしょうか?

「リスクチェーンモデル」とは、信頼できるAIサービスの実現に向けたリスクコントロール検討のアプローチです。AIサービスの「重要なリスク」は

①AIサービスの内容によってリスク要因が異なる(経済性、変化の影響、安全性、倫理、法令遵守、利用者起因のリスク等)

② ステークホルダー(関係者)によって重要な価値・目的が異なる(ビジネス目的の達成、納得のいく説明、公平な判断等)

これらを踏まえて、 AIサービスが「実現すべき価値・目的」を明確化し、その価値・目的の実現を阻害する「重要なリスクシナリオ」を識別するアプローチなのです。腹落ちしたのは、国内外で発行されたAIの信頼性に係る各種ガイドラインの論点を整理し、リスク要因となる要素を以下3つの層に分類して整理している点です。これならわかりやすい。

(1) AIシステム:AIモデル、データ、システム基盤、その他の制御機能で構成される技術・テクノロジー

(2) AIサービス提供者:サービスマネジメント層(技術層を含みながら、行動規範、サービス運用、コミュニケーションで構成)

(3) ユーザー(AIを使う人):利用者層(AIサービスに対する正しい理解、正しい利活用、利用者環境で構成)

イメージは下の図のような感じです。

長くなってきましたので、後編でRCモデルの全体像とメリットを解説します。お楽しみに。

後編に続く・・