人事の可能性を無限にするAIの力で組織と人を幸せに(後編):AIを武器にする

こんにちは、Funleashの志水です。

前回は人事の領域においてAIの技術が著しく進化する中で、社会実装の拡大に伴ってAIの信頼性を損なうような問題が発生していること、想定されるリスクが複雑で多岐にわたっていることについて触れました。

前編はこちらからお読みください。

後編は東京大学未来ビジョン研究グループが開発した「リスクチェーンモデル(Risk Chain Model: 以下RCModel」を解説し、AIの力を使って組織と人を幸せにするという本テーマについて論じたいと思います。RCModelに関心がない方は最後の部分だけでも読んでいただけたらとても嬉しいです。

先に述べたようにAIを利用するうえで想定されるリスクは、サービスだけではなく倫理や法令順守に関わる内容など多岐に及びます。リスクを検討するにあたっては様々な観点からシナリオを検討することが必要だといわれています。

RCModelでは、AIサービスの提供者、AIを開発した技術者、ユーザーである利用者の役割を明確にした上で継続的な対話を行い、共通認識を促進することを狙っています。

各種ガイドラインで示されているリスクに加え、実際に起こった事故や問題(前編で紹介した過去の問題点)などを参照し、技術・法務・人事など異なる属性の人たちから構成されるグループで議論することを提唱しています。さまざまな機関から発行されている原則やガイドラインでは一般論・広範囲な指摘であるがゆえ、リスクの優先順位がつけづらく、リスク回避のための運用コストが莫大になる可能性があるため、導入の効果に支障をきたすことさえあります。

リスクの発生可能性や影響度を考慮して優先的に取り組むべきリスクを特定することは、実務の観点から大変有効だと思います。

RCModelの全体像をおさらいする

RCModelは、AIサービスによる「実現すべき価値・目的」を明確にして、それらを実現するときに阻害要因となる「重要なリスク・シナリオ」を描いて関係者(以下ステークホルダー)ごとに異なるリスク対策を検討する包括的なアプローチといえます。

(リスクチェーンモデル:RCModelガイドVer 1.0から。下の図を参照)

このモデルがわかりやすいのは、国内外で発行された各種AIガイドラインの論点を整理し、リスク要因となる構成要素を3つの層に分けて構造化している点です。

それぞれの層ごとにリスク要因を見ていきます。

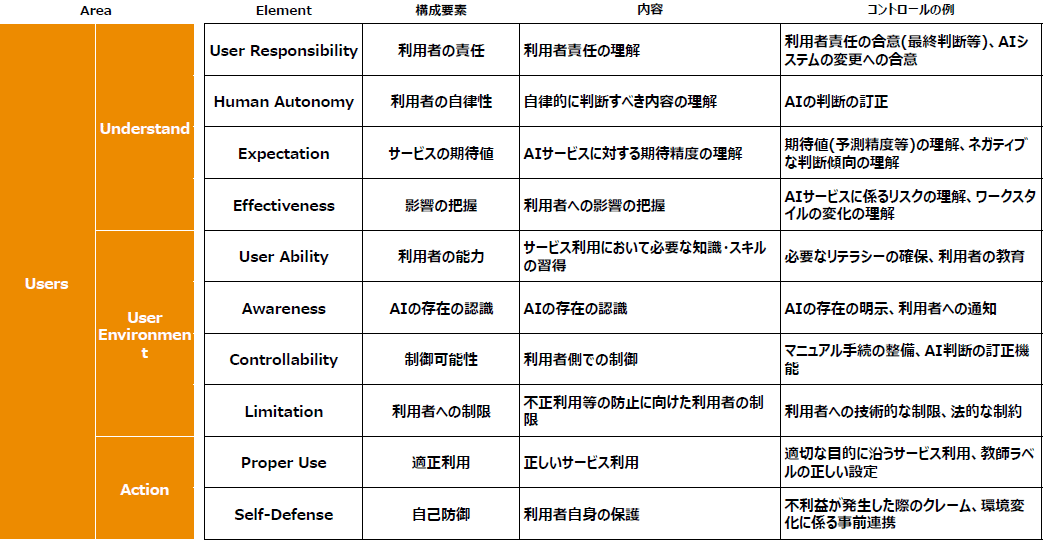

リスクの要因は、Area(領域)、Element(構成要素)、内容、コントロール事例から構成されています。

1)AIシステム:技術層(AIモデル、データ、システム基盤、そのほかの制御機能などで構成)

AI モデルやデータに関わること、安全性、操作の環境などシステム全般に関する要素が網羅されています。

品質はもちろん、事後検証できることは重要ですね。

2)AIサービス提供者:サービスマネジメント層(技術層を含みつつ、行動規範、サービス運用、コミュニケーションなどで構成)

AI サービスの使いやすさ、理解しやすさ、サポート面など幅広くカバーされています。安全性はもちろん、利用者との合意は見落とされやすい点です。

3)ユーザー:利用者層(AIサービスに対する正しい理解、正しい活用方法、利用者環境で構成)

読者の大半がおそらくAIの利用者だと思いますが、ユーザーとしてどんなリスクがあるのかを予測しておくことが必要です。不利益が発生した場合のクレームへの対処などは想定しておくことで損失を回避できます。

この3つの層を全体にまとめて、それぞれのリスク要因の関係性(リスクチェーン)をまとめたものが次の図になります。オレンジがユーザー層、グリーンがサービス提供者、ブルーがAIシステムのリスク要因となります。

RCModelを活用するためのステップ

次に、RCModelの利用方法について見ていきます。大きく二つのパートに分かれています。それぞれのパートにはいくつかステップがあります。

1「リスクアセスメント(リスクを測定する)」

2「リスクコントロール・コーディネーション(リスクコントロールを検討)」

Step1: 使用するAIサービスの「実現すべき価値・目的」を定義する

Step2: 重要なリスクシナリオを検討する

Step3: 重要なリスクシナリオごとにリスクチェーン(リスク要因の関係性)を検討する

Step4: リスクチェーンに従ってリスクコントロールを検討する

Step5: 各リスクチェーンで行った検討を元にステークホルダー事の役割を整理する

A社グループのグローバル各社における人材採用AIを検証する

リアリティを持たせるために、実際のサンプルケース(グローバル企業A社の「採用AI」)を参考にしながら、RCModelの各Stepを見ていきます。

事例の概要:A社における採用AI

◉A社グループの各社における人材採用部門がエントリーシートの書類選考を判断する際の参考情報として使用されるAIサービスである。

◉評価対象であるAIサービスプロバイダーのA社AI開発部門は、ビジネス利用者であるA社人材採用部門(海外グループ会社を含む)より過去のエントリーシートデータと合否判定(内定の判定)結果を受領し、機械学習で合否を判定する学習モデルを作成している。

◉適合率(Precision:書類選考で合格と判断した中で、面接を経て内定を出した割合)で評価し70%を期待値として設定している。

◉A社人材採用部門は新卒・中途両方のエントリーシート(電子ファイル)を学習モデルに読込み、自身のPC上(ブラウザ上)でAIの判断結果(合否判断)を確かめられる。

◉出力画面には合否判断のみではなく、エントリーシートで判断に影響したキーワードがハイライトされて表示される。人材採用部門担当者はAIの判断を参考情報として合否の判断を設定し、人材採用部門長の承認を得て、申込者に合否の通知を行う。

◉蓄積された本番データは採用・不採用の判定結果が入力されたタイミングで適宜学習データとして追加され、日次で学習モデルを更新して本番環境に反映する。

◉学習プロセスでテストの結果、正解率が70%を下回る場合には、本番環境のAIモデルを自動更新しない。過去1年分のバージョンを保存。

Step1: 使用するAIサービスが「実現すべき価値・目的」を定義する

まず最初に、AIサービスにおける「実現すべき価値・目的」を定義します。(下記を参照)

「人間よりも高度な検知」などのビジネス目的だけではなく、「不適切な利用の防止」「安全性の確保」など企業の社会的責任も含まれます。優先すべき価値・目的を明確に定義することがリスクを考える上で重要です。

・人材採用レベルの維持・向上

・採用活動に係るコストの削減

・海外グループを含めた子会社へのサービス提供

・公平性のある採用を通して企業の社会的責任

Step2: 重要なリスクシナリオを検討する

実現すべき価値や目的を阻害するリスクシナリオを検討します。例えば「無人化の実現」であれば「環境変化による精度劣化」「異常動作」等のサービス維持を阻害するリスクシナリオが考えられます。

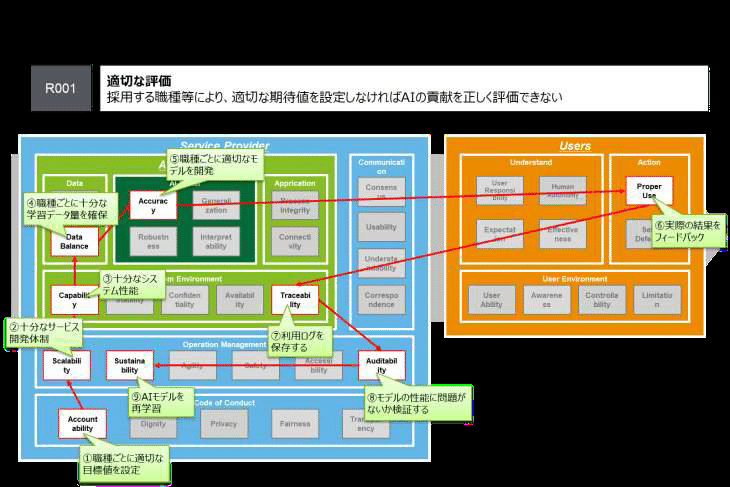

採用担当者として最大のリスクシナリオは恐らく「適切な評価: 職種により適切な期待値を設定しなければAIの貢献を正しく評価できない」ことだと思われます。

実現すべき価値・目的への影響度と照らし合わせ、リスクシナリオごとに複数のステークホルダーと優先度を検討します。

Step3: 重要なリスクシナリオごとにリスクチェーン(リスク要因の関係性)を検討する

リスクシナリオごとにRCModelの各層からリスク要因と関係性(リスクチェーン)を可視化します。

リスクが顕在化する順番を考えてリスクチェーン(線)を引いていきます。チェーンは一方向や単線であるとは限らず、どこが起点になるかは扱うリスクや問題によって変化します。例えばR001「適切な評価」に関するチェーンは下の図ようになります。

Step4: リスクチェーンに従ってリスクコントロールを検討する

リスクチェーンで関連づけられた各構成要素においてリスク対応策(以下コントロール)を検討します。

リスクコントロールが過剰・非現実的なものにならないように、リスクの大きさや費用対効果を踏まえ、最適なリスクコントロールを検討します。

多くのリスクシナリオでは複数の層に線が引かれるため、開発者だけではなく、サービス提供者や利用者もAIのリスク対策や責任範囲を考える必要があります。

これがRCModelの特徴です。

Step5: 各リスクチェーンで行った検討を元にステークホルダー事の役割を整理する

各リスクシナリオについてリスクチェーンを用いてリスクコントロールを検討したら、社内外の各組織/委託先/利用者を含む各ステークホルダーの役割を整理します。「実現すべき価値・目的」「重要なリスクシナリオ」「各ステークホルダーの役割」に係る一連の検討過程を整理します。これによってステークホルダー間で共通認識を持つことができます。

登壇がきっかけで、RCModelの手法と出会ったのですが、とても興味深いと感じたのは次の点です。

1)リスク要因とチェーン(関連性)を可視化するため文章よりも理解しやすい

2)多岐にわたるリスクを低減させるという非現実的なアプローチではなく、リスクの大きさや難易度、費用対効果などを考慮しつつ、実行可能な対策が立てられる

3)関係するステークホルダー(サービス提供者、技術者、利用者)の責任範囲を明確にして共通理解を持つことで対話の枠組みとして使える

RCModelの詳細について興味がある方はこちらを参照ください。

最近ではガイドライン・ルールに加えて、倫理問題を回避するためのテクノロジーの開発も急速に進んでいます。安全を実現するAIの研究・開発の取り組みは引き続き注目したいものです。

AIは組織と人間が幸せになるための最大の武器

ここまでAI活用における課題やリスクを整理してきました。AIというテクノロジーは著しく進化しており、まだまだ未知の部分が多いため、利用する側に不安があることは冒頭に述べました。前編を読んでAI使用について批判的・懐疑的なコメントを複数の方からいただきました。

今回のNoteを書くにあたってAIの信頼性に対する問題や想定されるリスクを調べた中で明確にわかったことがあります。それは、「データを取得される側が何らかの判断をされることで一方的な不利益を被ること」ということを人々が一番恐れていることです。さまざまなリスクや不安は、結局ここにつきるのだと思います。

一方で、私自身は人事の領域こそ、AIをもっと活用していくべきだと思います。

人事のミッションは事業を成功に導くために人的資源を最大化することであり、同時に組織で働く人たちの人生を豊かにする。AIはこのミッションを実現するための私たちの最大の武器になると信じているからです。

私たち人間の能力そして時間には限界があります。例えば、

💡何千、何万という採用者からのエントリーシートや履歴書すべてに目を通して常に同じ判断基準を用いて適正な選定ができるでしょうか?

💡組織の中で働いているすべての人たちの能力やスキル、希望のキャリアを経営や人事は把握しているでしょうか?

💡希望にそぐわない配置や転勤をされたり、強みを活かせない仕事をやらされたり、業績や能力が過少評価されている社員がいないでしょうか?

以前人事責任者をやっているときに、社員がどんなことを考えているのか、将来どんなキャリアを描いているのか、やりがいを感じてイキイキと働いてるのだろうか。これらを知りたくて、可能な限り対話に時間を割いていました。社員全員と定期的に1 on 1やれたらなあと思いながらもどかさしさを感じました。何千人の社員と実施することは現実的には難しい。

でもAIを使えば、組織に埋もれている情報や社員の声をひろいあげたり、社員のニーズをくみ取ることができるようになります。人間が見落としていること、不可能だとあきらめていたことが可能になる。進化し続けるAIという最強の道具があれば、事業も組織も社員ももっと良くなる。人事の未来はもっと明るくなるはずです。

今回、インタビューを行った実務専門家の全員が口を揃えて言いました

最適な提案をしてくるのはAIかもしれませんが、最終的に判断・結論を出して結果を説明するのは人間です。

バイアスや差別、偏見があるとすれば、それはわれわれ人間の問題なんです。

AIに丸投げするのではなく、最終的な決定は人間が責任を持って行うこと。管理・監視されたり、選定されたり、不利益を被るのではないかと不安に思っている人々に対して堂々と言いたいです。

皆さんが自分の能力を最大限に活かしてもっと活躍の場を広げるために活用しています。個人にも大きなメリットがあるのです。

どんなシステムにもリスクはつきものです。事故や問題を過度に恐れて使わないと、知見が深まらず、学習データも整備されません。トライアンドエラーの経験を重ね、失敗や成功から学べば、次第にAIリテラシーが高まってリスクコントロールもできるようになるはずです。

私たち人間がAIとともに進化する。

働く人の幸せのために。

私たちの未来をより良くするために。